Overview of object detection methods based on LiDAR point cloud under adverse weather conditions

-

摘要:

随着传感器、数据处理、视觉感知、控制决策、人工智能等自动驾驶相关技术的不断发展,自动驾驶成为汽车行业未来发展的重要方向之一. 但是,以雨、雾、雪等复杂天气为典型代表的极端驾驶环境,对自动驾驶环境感知提出了严峻挑战. 随着激光雷达(Light detection and ranging,LiDAR)在汽车上得到广泛运用,基于车载激光点云的目标检测已成为自动驾驶环境感知的重要研究方向之一,但在复杂天气条件下,LiDAR探测生成的点云存在大量噪点,对目标检测的性能产生严重负面影响. 对此,本文首先归纳了点云目标检测的基本定义、任务方法和评测指标,然后分析了复杂天气对点云目标检测的影响,并从数据增强、点云去噪、域自适应以及传感器融合等四个方面,系统分析了复杂天气下基于车载激光点云的目标检测方法及其优缺点,最后探讨了当前存在的数据规模与真实性不足、模型结构复杂、数据分布不均匀、实际部署瓶颈等问题以及未来研究方向.

Abstract:With the rapid development of autonomous driving technologies, including sensors, data processing, visual perception, vehicle control, decision making, and artificial intelligence, achieving fully automated Level-5 autonomous driving has become a critical direction for the future of the automotive industry. Object detection lies at the core of autonomous driving systems. It analyzes surrounding-environment data obtained from onboard sensors so as to determine the position, category, size, and posture of objects in the road environment. Object information provides critical support for localization, navigation, path planning, and motion control. Of the many environmental perception sensors, light detection and ranging (LiDAR), which provides high-precision three-dimensional point cloud data, plays a vital role in environmental perception of and object detection by autonomous driving systems. Advanced LiDAR-based object detection methods leverage deep learning techniques to extract object features, predict object locations, and classify objects within an end-to-end neural network framework, achieving remarkable accuracy in many general scenarios. However, adverse weather conditions, such as rain, fog, and snow, notably affect the quality and reliability of LiDAR point cloud data. These conditions introduce challenges, such as increased noise in point clouds, occlusion of foreground objects, weakening of point intensity, reduction in sensor confidence, and difficulties in data acquisition, all of which degrade the performance of general object detection methods. Consequently, addressing the robustness of LiDAR-based object detection under adverse weather conditions has become a prominent research focus. Aiming at overcoming these challenges, various methods have been proposed to enhance object detection performance, including strategies that enhance the robustness of object detection networks under complex weather environments. This study comprehensively reviews state-of-the-art object detection methods based on LiDAR point clouds under adverse weather conditions. To establish the research background, we first summarize the basic concepts, tasks, methods, and evaluation metrics of point cloud object detection while analyzing the specific effects of adverse weather on detection performance. Following this, we systematically categorize the existing object detection methods into four main approaches: (1) data enhancement-based ones, which enhance network robustness via augmentation of training datasets to account for weather variations; (2) point cloud denoising-based ones, which mitigate the effect of weather-induced noise via cleaning of raw point cloud data, thereby increasing detection accuracy; (3) domain adaptation-based ones, which use models trained under favorable weather conditions to guide the training of networks designed for adverse weather so as to enhance the model’s generalization ability; and (4) multisensor fusion-based ones, which enhance detection performance via integration of multimodal data from various sources, such as combining LiDAR with camera or radar. Each of these methods is reviewed in detail, with their strengths and limitations analyzed. Furthermore, this study speculates that future research will continue to adopt deep learning methods and innovate in four aspects: data, models, learning strategies, and practical applications. By analyzing in detail the current status of research and identifying the pressing challenges, this review aims to offer valuable insights and inspiration for subsequent studies, ultimately facilitating the development of robust object detection technologies under adverse weather conditions.

-

Keywords:

- LiDAR /

- object detection /

- autonomous driving /

- adverse weather conditions /

- deep learning

-

自动驾驶技术的崛起标志着交通领域迎来一场深刻变革. 作为自动驾驶系统的“眼睛”,环境感知模块是保障系统安全性、稳定性和精确性的重要组成部分. 在众多环境感知传感器中,激光雷达(Light detection and ranging,LiDAR)凭借其分辨率高、探测性能好、抗干扰能力强、体积小、质量轻的优势,已成为自动驾驶系统的主流车载传感器之一. 然而,复杂天气条件(如雨、雪、雾等)对激光点云数据的质量和可靠性产生了显著影响,成为自动驾驶环境感知面临的重大挑战之一. 本文从算法层面对复杂天气下车载激光点云目标检测方法进行全面综述. 首先,介绍点云目标检测的基本任务、代表性方法及评价指标,并分析复杂天气下点云的特点及挑战. 然后,对现有的复杂天气下车载激光点云目标检测方法进行分类和详细探讨,分析不同检测方法的工作原理及其在复杂天气下的表现. 最后,总结现有方法存在的问题,并提出未来的研究方向.

1. 点云目标检测

点云目标检测通过分析处理车载激光传感器获取的点云数据,得到道路环境中各个物体的位置、类型、尺寸、姿态等信息,为自动驾驶系统的定位导航、路径规划及运动控制提供重要支持.

1.1 车载激光点云

LiDAR能够快速探测并获取表征道路环境结构信息的三维点云数据,表示为$ P=\{{p}_{i}=[{x}_{i},{y}_{i},{z}_{i},{r}_{i}{]}^{\mathrm{T}}\in \mathbf{R}{\}}_{i=\mathrm{1,2},\cdots ,M} $,其中$ {x}_{i} $,$ {y}_{i} $,$ {z}_{i} $代表每个点在三维空间直角坐标系的X、Y、Z轴上的坐标,$ {r}_{i} $表示激光的反射强度(可作为附加特征维度),M为点的总数.

1.2 点云目标检测任务

点云目标检测[1]以三维点云为输入,通过目标检测方法处理分析点云数据,生成物体类别属性以及表征物体位置的三维目标框. 三维目标框通常使用$ ({c}_{x},{c}_{y},{c}_{z},h,w,l,\theta ) $表示,其中$ {c}_{x} $,$ {c}_{y} $,$ {c}_{z} $为目标框的中心点坐标,$ h $,$ w $,$ l $分别为目标框的高度、宽度和长度,$ \theta $为目标框的航向角.

点云目标检测任务要求高精度、实时性和强鲁棒性. 由于道路场景复杂多变,通常包含车、行人、自行车等多种物体,目标检测需要识别和定位不同类别的目标,并尽量减少误检和漏检,确保高检测精度. 为保障自动驾驶系统的安全,目标检测需满足实时性,在短时间内迅速反应. 此外,目标检测还需具备鲁棒性,在多种天气及遮挡构成的复杂干扰环境中依然保持准确性.

1.3 通用场景下的点云目标检测方法

早期的点云目标检测方法通常采用欧氏聚类法[2]对点云进行处理,即首先在整个点云上构建K维搜索树,然后将半径阈值内的所有邻近点划分为一个实例. 聚类算法以其简洁性和可解释性,被广泛应用于点云目标检测任务之中,但对参数较为敏感,其结果的质量严重依赖于参数调整的质量,并且缺少对语义特征的提取与运用,难以应对环境干扰、物体形态变化等问题.

由于深度神经网络[3]具有强大的特征表示学习能力、对任意非线性函数的拟合能力以及基于数据驱动的参数学习能力,深度神经网络被逐渐应用于三维点云的特征提取. 根据三维点云的编码方式,基于深度神经网络的点云目标检测方法可以分为基于体素网格的方法和基于点的方法. 基于体素网格的方法通过将点云投影到图像[4]或将点云细分为均匀分布的体素[5−6],实现点云从稀疏表示形式到紧凑表示形式的转换,从而可将成熟的二维目标检测网络模型应用于密集的体素网格之上. 在此基础上,研究人员提出使用稀疏卷积[5]、子流型卷积[7]、形变卷积[8]等操作提升网络对体素网格特征提取的精度和速度,促进了点云目标检测网络模型的发展. 然而,大规模点云在体素网格化过程中会产生较大的信息损失,导致该类方法的检测性能大幅下降. 相较于基于体素网格的方法,基于点的方法[9−11]直接在原始点云上进行特征提取和目标边界框预测,从而保留了更为精细的点云特征,并取得更好的性能表现,但是其需要更长的推理时间. 对此,为提升直接处理原始点云方法[12−13]的计算效率,文献[14]提出了基于中间特征的点采样策略,通过引入前景点采样来弥补特征聚合网络对点云特征提取能力不足的问题,从而在不影响检测召回率的同时,实现了实时目标检测效率. 在此基础上,文献[15]提出基于语义增强的点采样,实现了在下采样期间对更重要的前景点保留. 以上研究工作对通用的三维点云目标检测方法的研究起到了推动作用,而且许多方法已在常规自动驾驶数据集上实现了良好的检测性能. 但是,在复杂天气条件下,现有的通用点云目标检测方法的检测性能会出现大幅下降[16−17].

1.4 点云目标检测评价指标

点云目标检测的评价指标包括检测精度评价指标和算法运行速度评价指标.

在精度评价指标方面,将点云目标检测的预测结果和真实数据标签进行对比,通过计算交并比(Intersection over union,IoU)判别预测结果正确与否. 精度(Precision)指标:全部预测目标中正确目标的占比,体现查准率. 召回率(Recall)指标:全部真实目标中被正确预测目标的占比,体现查全率. 平均精度(Average precision,AP)指标:在不同召回率下的平均精度值,体现综合准确率. 绘制精度–召回率(Precision–Rrecall,P–R)曲线,计算其与坐标轴围成的面积.

速度评价指标定义为算法每秒处理点云帧数(Frame per second,FPS). 检测速度取决于模型复杂度、点云数量、分辨率及计算设备性能. 需在同一计算设备和点云尺寸下进行对比,才具参考价值.

2. 复杂天气的挑战

自动驾驶系统的传感器需长期暴露在复杂多变的天气中,这为传感器性能和目标检测方法带来了诸多挑战. 车载激光雷达目标检测需在晴天、雨天、雪天、雾天等多种气候条件下稳定运行,而复杂天气不仅会削弱激光雷达的探测能力,还会改变点云数据的特性.

2.1 复杂天气下点云的特点

在复杂天气条件下,点云数据会发生显著变化,影响目标检测方法的性能,具体表现为:

(1)噪声点增多. 车载LiDAR的工作波段通常在800~

1000 nm和1300 ~1600 nm之间,而该波段的激光脉冲难以穿透雨、雪、雾等大气颗粒,容易产生反向散射,导致激光雷达探测到额外的无效天气噪声点. 在生成的点云中,这些噪声点随机分布,可能遮挡物体目标点,影响物体形状和轮廓特征,破坏物体的语义一致性,从而对目标检测性能产生不利影响.(2)信号衰减. 雾、雨、沙尘等天气会导致激光信号衰减,缩小LiDAR的探测范围,使远距离目标的点云更加稀疏. 当激光穿透力减弱时,对于远距离或低反射率物体,点云反射点较少甚至缺失,这大幅增加了目标检测难度,导致检测算法难以识别这些目标.

(3)传感器置信度降低. 复杂天气下环境噪声增大会导致点云信噪比降低,尤其在大雨或大雪天气中,激光雷达每个测量点的有效信息比例减少,噪声干扰增多,从而降低了结果的可靠性和传感器的置信度,增加了传感器融合的难度.

(4)数据采集困难. 复杂天气下的驾驶风险增高,传感器设备易受损,且数据采集时间和环境受限,这限制了在复杂天气下的点云数据获取能力. 数据的稀缺导致网络模型训练后的泛化能力不足,易出现过拟合情况,难以有效验证模型效果.

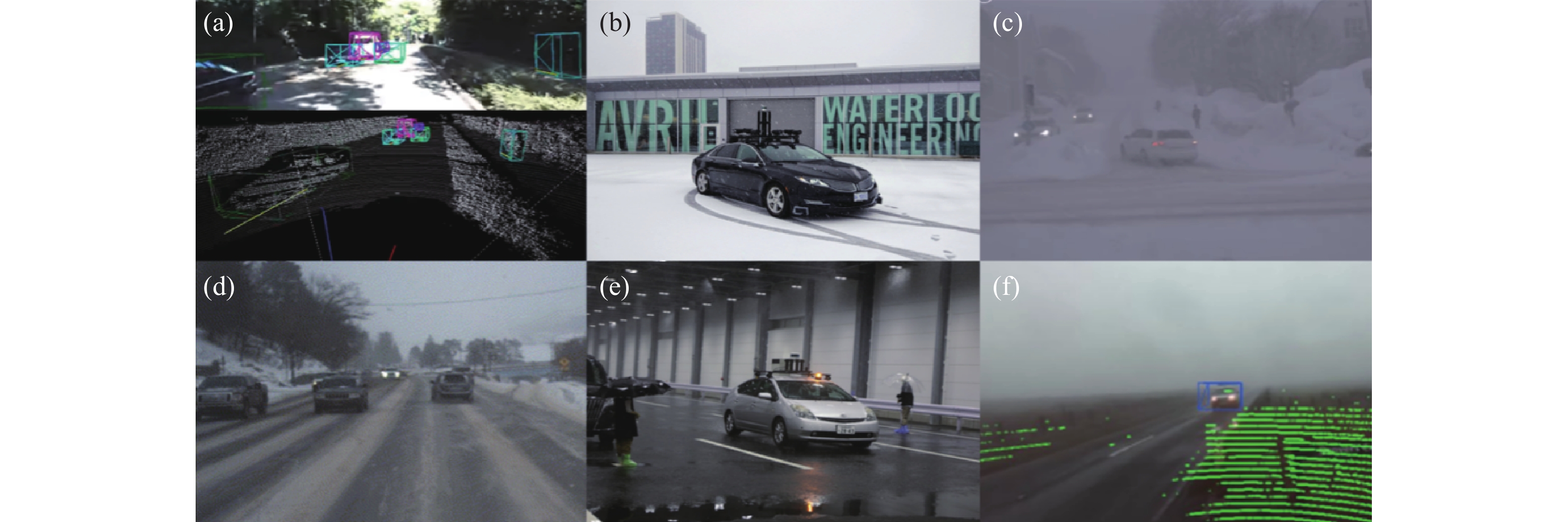

2.2 复杂天气下点云目标检测数据集

2012年以来,自动驾驶领域发布了多个LiDAR点云目标检测数据集[18−20],并提供数据标注、评价指标和排行榜. 表1总结了点云目标检测最常用的三个主流数据集以及用于研究复杂天气条件下点云目标检测的公开数据集,其中部分数据集的采集环境如图1所示. 主流数据集多为在开放道路上随机采集的数据,由于天气变化的随机性,主流数据集中复杂天气场景下的点云数据较少,故仅使用主流数据集进行复杂天气下点云目标检测方法的研究,难以满足点云目标检测任务的鲁棒性要求.

表 1 复杂天气下点云目标检测数据集Table 1. LiDAR object detection datasets acquired under adverse weather conditionsType Dataset Scene Weather LiDAR Ground truth Open road Chamber Rain Fog Snow Classes Annotations Main-

streamKITTI[18] √ HDL-64E 3 2.0×105 nuScenes[19] √ √ HDL-32E 23 1.4×106 Waymo[20] √ √ 1×360° 75 m range, 4×LaserBear Honeycomb 4 1.2×107 Adverse

weatherCADC[21] √ √ VLP-32C 10 3.0×105 STF[22] √ √ √ √ √ VLP-32C, HDL64-S3 4 1.0×105 WADS[23] √ √ 2×VLP-16 22 pointwise 3.6×109 LIBRE[24] √ √ √ VLS-128, HDL64-S2, HDL-32E, VLP-32C, VLP-16, Pandar64, Pandar40P, OS1-64, OS1-16, RS-Lidar32 Oxford RobotCar[25] √ √ √ √ 2×SICK LMS-151 (2D), SICK LD-MRS (3D) RADIATE[26] √ √ √ √ 2×HDL-32E 8 2.0×105 SemanticSpray[27] √ √ VLP32C 1 pointwise SemanticSpray++[28] √ √ VLP32C 2 3.0×103 ![]() 图 1 点云目标检测数据集采集环境. (a) KITTI数据集[18](晴天开放道路); (b) CADC数据集[21](雪天开放道路);(c) STF数据集[22](雪天开放道路); (d) WADS数据集[23](雪天开放道路); (e) LIBRE数据集[24](雨气象室); (f) RADIATE数据集[26](雾天开放道路)Figure 1. Acquisition environment of point cloud datasets: (a) KITTI dataset[18] (clear weather open road); (b) CADC dataset[21] (snowy open road); (c) STF dataset[22] (snowy open road); (d) WADS dataset[23] (snowy open road); (e) LIBRE dataset[24] (rainy weather chamber);(f) RADIATE dataset[26] (foggy open road)

图 1 点云目标检测数据集采集环境. (a) KITTI数据集[18](晴天开放道路); (b) CADC数据集[21](雪天开放道路);(c) STF数据集[22](雪天开放道路); (d) WADS数据集[23](雪天开放道路); (e) LIBRE数据集[24](雨气象室); (f) RADIATE数据集[26](雾天开放道路)Figure 1. Acquisition environment of point cloud datasets: (a) KITTI dataset[18] (clear weather open road); (b) CADC dataset[21] (snowy open road); (c) STF dataset[22] (snowy open road); (d) WADS dataset[23] (snowy open road); (e) LIBRE dataset[24] (rainy weather chamber);(f) RADIATE dataset[26] (foggy open road)为应对复杂天气的挑战,学术界和工业界推出了专门针对复杂天气的点云目标检测数据集,这些数据集涵盖了典型的复杂天气场景,为检测算法的开发、优化与评估提供了重要支持. CADC[21]记录了加拿大冬季场景下的车载点云数据,并提供了车辆和行人两个类别的目标框标注. STF[22]包含在北欧收集的晴、雨、小雾、浓雾和以及雪等天气条件下的车载点云数据,并提供汽车、行人、自行车骑行者和卡车等类别的目标框标注. WADS[23]是由美国密歇根州冬季雪天道路点云数据构成,并提供了比目标检测标注框更细粒度的逐点标注. LIBRE[24]采集于气象室,记录了人工控制的雨雾天气条件下带有定点障碍物的室内点云数据. Oxford RobotCar数据集[25]记录了一年内各种天气条件下英国牛津市内多条固定驾驶线路的车载多传感器数据,由于该数据集主要是为SLAM任务而设计,故没有提供目标框标注. RADIATE数据集[26]涵盖了晴天、夜晚、雨、雾和雪等天气条件下,城市、高速公路、郊区和停车场等驾驶场景中的多传感器数据,并人工标注了图像数据中的目标框,而毫米波雷达和LiDAR数据中的目标框则是根据传感器标定结果自动关联得到. SemanticSpray[27]对包含了雨天道路中的具有飞溅点的点云数据集RoadSpray[29]其中的点云进行了语义分割标注,将点云中的点分为背景、车辆、喷溅三个类别,并利用VoxelNeXt[30]和语义分割标签自动生成了目标框标注[31],该研究小组在后续发布了包含相机、激光雷达以及雷达的多传感器数据集SemanticSpray++[28],并对激光点云中的汽车和货车两个类别进行了手动标注.

3. 面向复杂天气的点云目标检测方法

在复杂天气条件下,通用的点云目标检测方法的检测性能出现明显下降. 对此,主要有四类方法对复杂天气下车载激光点云目标检测进行改进:一是基于数据增强的方法,通过增加训练数据量,增强目标检测网络的鲁棒性;二是基于点云去噪的方法,通过清洗原始点云数据中的天气噪点,增强目标检测网络的精度;三是基于域自适应的方法,通过良好天气条件下训练的网络知识指导复杂天气目标检测网络的学习过程,增强目标检测网络的泛化性;四是基于多传感器融合的方法,通过整合来自不同数据源的多模态信息,增强目标检测网络的性能. 本章将从以上四个方面,对复杂天气下车载激光点云目标检测方法进行总结.

3.1 基于数据增强的方法

目标检测网络的性能高度依赖于有标注训练数据集的质量. 而点云目标检测的数据获取成本高,数据标注难度大,且涵盖复杂天气场景的点云数据则更为稀缺. 对此,研究人员提出使用晴朗天气点云数据生成复杂天气点云数据,对深度神经网络进行数据增强.

3.1.1 复杂天气点云模拟

文献[32]提出基于理论激光雷达模型对雨、雾和雪的影响进行建模,实现从晴朗天气点云到相应复杂天气点云的映射. 文献[33]提出了一种更实用的雾天点云模拟模型,该模型基于测量强度、LiDAR参数和雾中光学可见度等变量构造最大观测距离函数,如果晴朗天气下点云中某点的距离低于最大观测距离,则以一定的概率设置随机散点或丢失点. 文献[34]将能见度参数和散射概率转换为降雨率,将文献[33]中的雾模型扩展为降雨模型. 为达到更为真实的降雨模拟,文献[35]提出雨滴会导致点散射或丢失,具体是否保留该点取决于衰减后的点强度是否低于LiDAR的最小可检测强度. 文献[36]进一步考虑了雨中LiDAR脉冲的光束发散度,即计算模拟发散光束与球形雨滴超采样光束的交点数量,并根据阈值判断是否添加散射点,文献[37]则将该方法扩展至雪、雾天气下的点云模拟.

文献[38]提出了一种基于功率域的雾、雪、雨等天气条件下的点云模拟模型,使用计算更有效的散射点距离采样策略来模拟光束发散. 该模型首先将物体和随机采样散射体反射的衰减功率与距离相关的噪声阈值进行比较,如果散射点的功率超过物体对象的功率,则会添加散射点;如果某个点的功率低于与距离相关的噪声阈值,则该点将丢失. 与文献[38]相反,文献[16]和文献[17]根据文献[33]中的理论公式明确了强度分布的计算,通过分析不同的散射体和物体对回波峰轮廓的联合贡献,该方法能更精确地建模遮挡效应,构建更真实的雾、雪天气仿真模型. 针对雪天模拟,文献[17]引入了湿地面增强模型,可以模拟由于道路上的水膜而丢失的地面点,与文献[38]中使用的启发式方法相比,该方法采用了数据驱动为主的方式估计本底噪声. 文献[39]提出了一种物理上合理的方法来估计衰减和后向散射系数,以进一步改进文献[16]中的雾模拟模型.

近期,深度学习技术被应用于点云数据的模拟生成[40]. 受基于生成对抗网络图像翻译的启发,文献[41]开创性地提出将三维LiDAR点云表示为二维(2D)鸟瞰图(Bird eye view,BEV)或2D极坐标网格地图等图像数据形式,实现模拟点云数据集CARLA[42]与真实点云数据集KITTI之间的转换. 无需配对数据,使用CycleGAN生成对抗网络[43]来学习从模拟到真实、从低分辨率到高分辨率的LiDAR点云图像转换. 文献[44]对上述方法进行扩展,实现将点云从晴天转换到雾天或雨天.

3.1.2 使用复杂天气点云进行数据增强

生成含有天气噪声的点云数据后,可在点云目标检测网络的训练过程中进行数据增强,例如将原有的晴天点云数据与具有天气噪声的点云数据混合以扩充训练数据,或全部使用含噪声的点云数据进行训练,以提升网络对天气噪声的适应性,从而在真实的复杂天气环境中具有较好的鲁棒性.

文献[17]使用所提出的雪模拟方法,将STF中的晴天点云数据转换为模拟的雪天点云作为训练集进行数据增强. 在真实雪天点云数据上的测试结果表明,尽管不同的目标检测方法对降雪数据的鲁棒性不同,但经过数据增强后目标检测网络的平均精度均有提高,同时不会牺牲晴朗天气下的目标检测精度. 另外,物体的大小和形状也影响着目标检测网络的性能和不同天气下数据增强的效果,对于较小和区分度不足的目标,如自行车骑行者和行人,检测精度更容易受复杂天气的影响而降低,而数据增强可以大幅提升这类目标在复杂天气下的鲁棒性. 文献[16]对于雾天目标检测也得到了相似的结论. 除点云数据增强外,文献[45]发现增加训练集目标框标注的数量和多样性,即使仅使用晴朗条件下的点云数据对目标检测网络进行训练,其在复杂天气下也能表现出较好的性能.

真实复杂天气条件下获取的点云目标检测数据集大多天气类型单一,和主流的点云目标检测数据集相比,数据量和标注框太少,难以满足深度神经网络的训练需求. 通过模拟合成复杂天气点云数据或增加目标框数量的方式进行数据扩增,能够显著提升目标检测模型在复杂天气下的检测精度. 同时,在复杂天气点云模拟的过程中,提升合成点云数据的真实度,可以在更大程度上提升目标检测的精度.

3.2 基于点云去噪的方法

复杂天气所产生的影响是以特定噪声模式反映在LiDAR点云中. 去除点云中的天气噪声点,恢复清晰点云,可以为目标检测提供高质量点云数据,提升目标检测效果. 目前,点云去噪主要包括基于滤波的去噪方法和基于深度学习的去噪方法. 去噪后的清晰点云可以直接送入晴朗天气点云数据集上训练的目标检测网络进行目标检测.

3.2.1 滤波去噪

半径滤波(Radius outlier removal,ROR)[46]去噪算法通过计算每个点在特定搜索半径内的相邻点数量判断该点是否为噪点,当相邻点的数量低于定义的阈值时,该点被归类为噪声点. 由于点云随着距离增加而逐渐稀疏,导致远处的物体点经常被错误地归类为噪声点,动态半径滤波(Dynamic radius outlier removal,DROR)[47]去噪算法根据距测量点的距离动态改变搜索半径值,而非使用静态的搜索半径. DROR对于雪噪声点的检测精度和召回率可达到90%,然而受运行速度的限制,DROR难以应用于具有高实时性需求的任务.

统计滤波(Statistical outlier removal,SOR)[46]去噪算法使用点云的统计特征作为去噪依据. 在无噪声情况下,点云整体应呈现出较为均匀的分布,即点云内每个点与和它K个最近邻点之间的平均距离不会超过阈值,超过则视为噪声点. 阈值由平均距离的统计特征(均值和标准差)计算得到. 快速聚类统计滤波(Fast cluster statistical outlier removal,FCSOR)[48]去噪算法在计算平均距离之前,使用体素网格对点云进行降采样,以降低计算复杂度,但比SOR的精度略有下降. 动态统计滤波(Dynamic statistical outlier removal,DSOR)[23]去噪算法动态地改变SOR阈值的范围,对雪天点云数据去噪的召回率和计算速度均有提升.

利用雨雪噪点反射强度较小的特点,低强度值滤波(Low-intensity outlier removal,LIOR)[49]去噪算法提出将低于反射强度阈值的点视为噪声点. 为减少误报率,还对噪声点进行二次筛选,若在距该点的指定距离内检测到多个相邻点,则认定该噪声点为正常点. LIOR的计算速度比SOR快12倍,比DROR快8倍,但该方法仅可在小范围区域内实现高速情况下的实时车载点云噪声过滤,却难以实现对整个大规模点云的实时处理. 从噪声过滤精度来看,在同样近100%召回率的情况下,LIOR比DROR的误报率降低约47%.

3.2.2 深度学习去噪

深度学习的快速发展为解决各类问题提供了一种新的思路. 与基于滤波的去噪算法不同,基于深度学习的点云去噪网络往往包含大量可训练参数,故能够直接理解天气噪声的潜在结构. 文献[50]第一个将卷积神经网络应用于激光点云去噪,提出了雨雾点云去噪网络WeatherNet,以及数据标注、增强方法. WeatherNet的输入为三维点云的2D投影图像,并采用LiLaNet[51]作为基础网络结构,在此基础上减少网络的深度以降低计算复杂度,在卷积层中使用扩张卷积以增大感受野,增加丢弃层以提升模型泛化能力,网络最终输出逐点的多类语义分割结果. 由于缺乏在复杂天气条件下逐点标注的点云数据,文献[50]中使用受控的气候室来收集多天气点云数据并进行自动真值标注,使用雨雾模型进行数据增强以获取更大规模的训练数据集. 训练后的网络在噪点过滤精度和速度上都取得了很好的效果,对于雾和雨的噪点去除远优于DROR. AWNet[27]网络提出基于能量的噪点检测框架,将低能量分数与内点关联,将高能量分数与噪点关联,在训练的过程中以能量函数的形式计算分类损失,推理过程会返回能量得分,根据能量得分的阈值即可判断是内点还是噪点,其对噪声点的识别准确度相比DROR[47]和DSOR[23]提升近40%,相比WeatherNet[50]提升10%.

时空数据的运用对于点云去噪至关重要,从空间维度来看,点云噪声的密度相对较低;从时间维度来看,有效点遵循可预测的轨迹. 文献[52]提出可处理点云时空特征的4DenoiseNet网络,通过两个网络分支分别提取不同度量空间下的特征信息,并使用运动引导注意力机制进行分支特征融合,输出逐点分类结果,并由掩码模块去除噪声点. 4DenoiseNet在SnowyKITTI的模拟雪天点云数据集上进行了训练和测试,比WeatherNet的精度提高近10%,比DROR、LIOR的精度提高近50%.

为解决缺少标注数据的问题,文献[53]提出一种无监督的点云去雪网络LiSnowNet,设计了量化点云图像及噪声稀疏性的损失函数指导网络训练. LiSnowNet可以实时运行,在7 ms内可处理十万个点,比基于滤波的无监督方法DSOR和DROR分别快52倍和158倍,同时在现有的先进方法中具有最高的精度并保持仅次于DSOR的召回率. 文献[54]提出使用生成对抗网络CycleGAN的无监督方法,将噪声点云输入转换为清晰点云,然而其输出的点云仍然带有噪声,有待进一步完善.

3.2.3 基于去噪的点云目标检测

文献[31]提出了一种结合去噪模块的复杂天气下点云目标检测框架,对于激光雷达数据的去噪,他们使用了AWNet[27],首先将原始激光雷达点云作为输入,使用去噪模块区分点云的噪声点,并删除噪声点,再将去噪后的点云输入到目标检测器中. 该方法无需对目标检测网络进行重新训练,且去噪模块可以根据环境情况激活或停用. 为充分验证去噪模块的作用,作者使用不同的目标检测器进行了实验,结果表明,无论使用何种目标检测器,先去噪再检测的架构均能提升目标检测精度. 相较于未经处理的点云,去噪后点云的平均检测精度提升近10%. 作者还测试了不同点云去噪方法,结果表明,使用WeatherNet[50]方法去噪使平均检测精度提升最大,升幅为12%,而该模块耗时仅为4.18 ms,搭配快速目标检测器PointPillars[6]可实现实时点云目标检测.

天气噪声的变化频率高且状态多样,基于深度学习的去噪能在大量数据中学习噪声的高维空间和时间特征,故其在噪声过滤方面优于仅基于空间统计特征的滤波方法. 目前,缺乏逐点的噪声点云标注数据集是制约基于深度学习方法发展的主要瓶颈,因此基于无监督学习的训练方法逐渐受到广泛关注,但其去噪效果仍有较大提升空间. 点云去噪能够过滤大部分天气噪声点,得到的清晰点云可以直接用在晴天训练的目标检测模型,检测精度会有大幅提升.

3.3 基于域自适应的方法

基于数据增强和点云去噪的方法都是从数据层面上对点云进行处理,可以缓解复杂天气导致的目标检测性能下降,但均在目标检测算法外引入了额外的计算量. 对学习型算法而言,天气条件的变化是一种域迁移问题,即训练数据和测试数据采样自不同分布的数据集,而域自适应则常用于解决数据分布不一致的问题. 开发用于弥合域差异的域自适应方法,可以应对晴天目标检测网络对雨、雾、雪天目标检测网络的域迁移问题. 这类方法从经过训练的源网络中提取有价值的知识,指导目标网络进行端到端学习,而无需执行点云去噪等前置操作. 文献[55]虽全面概述了LiDAR感知的域自适应方法,但主要关注的是不同分辨率的传感器数据与其标注数据的相关性问题.

文献[56]在文献[6]所提网络结构的基础上进行改进,利用域自适应方法提高雪天条件下的目标检测性能. 该网络首先使用由点注意力和通道注意力构成的双注意力模块,重新加权堆叠输入特征,增强网络提取关键信息的能力;然后使用基于全局上下文的柱状特征细化提取模块,捕捉特征的长程依赖关系,减轻雪天点云场景中局部雪花噪声的干扰;最后设计了一个最大均方差模块,计算两个域特征的分布,在特征空间中最小化两个分布之间的距离,从而缩小不同天气条件下点云数据之间的域分布差异.

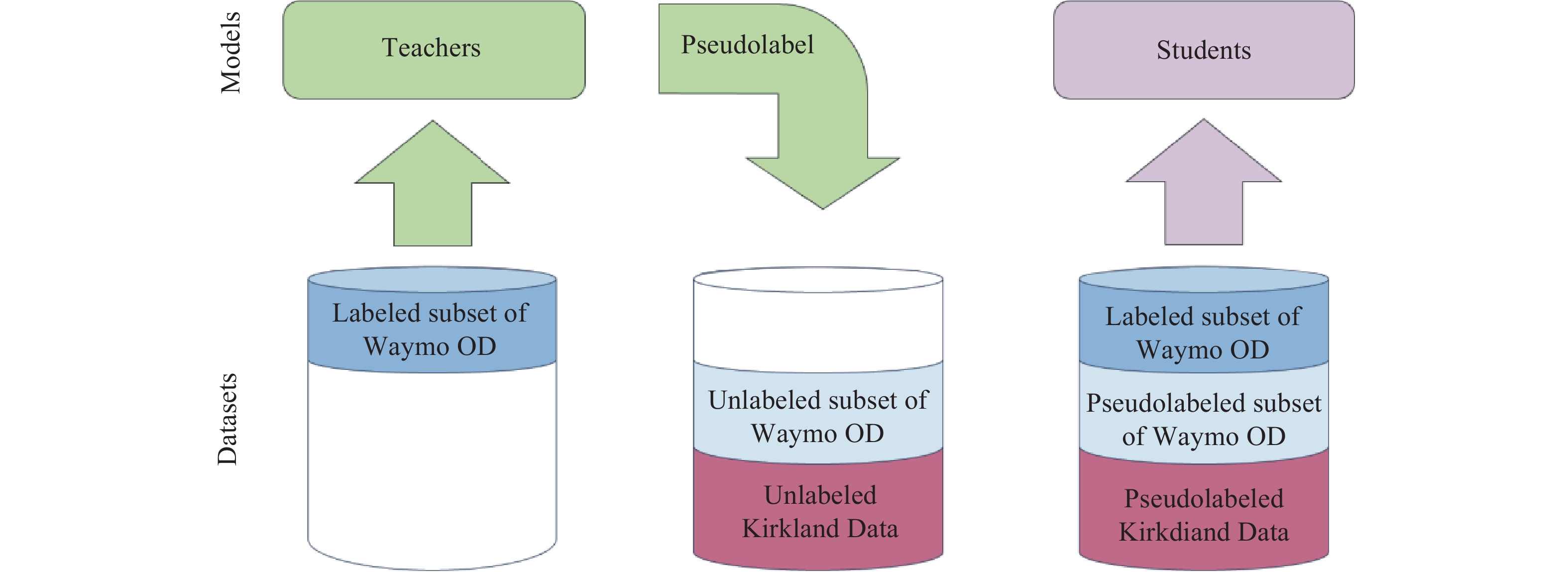

文献[57]提出在标签空间中应用知识蒸馏,实现从Waymo数据集中的San Francisco, Phoenix, Mountain View等有标注的晴天数据,到具有新地理和天气条件的Waymo Kirkland无标注雨天数据集的域迁移. 如图2所示,该方法首先使用源域(晴天)有标签数据训练并选择性能最佳的教师网络,再使用教师网络对目标域(雨天)的无标签数据进行标注,得到伪标签数据;然后混合有标签数据与伪标签数据,用于训练学生网络. 教师与学生网络均使用PointPillars[6]作为基础网络架构,但教师网络具有更多的卷积通道数并融合了多帧点云信息. 实验结果表明,具有高准确率的教师网络能够训练出高准确率的学生网络,但由于潜在的数据分布差异,两个网络在雨天数据集上的性能均低于晴天数据集的性能,而学生网络对雨天数据集具有更好的泛化能力. 文献[58]提出了LossDistillNet教师–学生网络结构,同样使用知识蒸馏实现网络从晴天到恶劣天气的域迁移. 首先使用晴天的KITTI数据训练教师网络,并使用通过LISA[38]模拟生成的复杂天气的KITTI数据训练学生网络,再将学生网络与教师网络预测结果的损失、学生网络预测结果与真值的损失分别作为知识蒸馏损失和学生网络分支损失,帮助学生网络学习到鲁棒的物体特征表示. 相比文献[57],LossDistillNet中教师网络和学生网络的结构更为复杂,其在VoxelNet[5]的基础上增加了稀疏卷积层[7],以及空间语义特征聚合和注意力融合模块. 另外,由于复杂天气条件下点云噪声和物体点丢失增多,加剧了输入教师和学生网络点云的分布差异,导致两个网络的预测结果差距增大,进而影响知识蒸馏的效果,因此,LossDistillNet的学生网络使用深度因子融合分析网络[59]和损失卷积层来恢复丢失的点云. LossDistillNet分别在雾天和雪天数据上进行了测试,与同样使用了知识蒸馏的SE-SSD网络[60]以及多传感器融合的Deep entropy fusion网络[22]相比有一定的精度提升.

知识蒸馏、域自适应技术为点云目标检测网络从晴天域推广到复杂天气域提供了可扩展的解决思路. 通过设置合理的训练方式,设计适宜的标签分配策略,以及定义域迁移相关损失函数,深度学习网络在训练后能够实现晴天域到复杂天气域的迁移,有助于模型压缩和高效推理,并在源域和目标域保持优异的性能.

3.4 基于多传感器融合的方法

为表征物体,理论上单模态数据表示是多模态数据表示的子集,而多模态数据表示能更好地描述物体特征[61−62]. 自动驾驶车辆中,最常见的传感器是光学相机、毫米波雷达(Radio detection and ranging,Radar)和LiDAR. 在复杂天气条件下,每个传感器的性能都会有不同程度的恶化,比如当遇到灰尘、雨、雪或雾等可见的空气传播颗粒时,LiDAR的感知会受到影响;光学相机则对光照强度更加敏感;Radar虽穿透力强,可以适应恶劣天气,但缺乏检测静态物体和精细结构的能力. 目前,已有大量研究着眼于将LiDAR与不同传感器获取的多模态数据进行融合,以提升复杂天气下目标检测的性能.

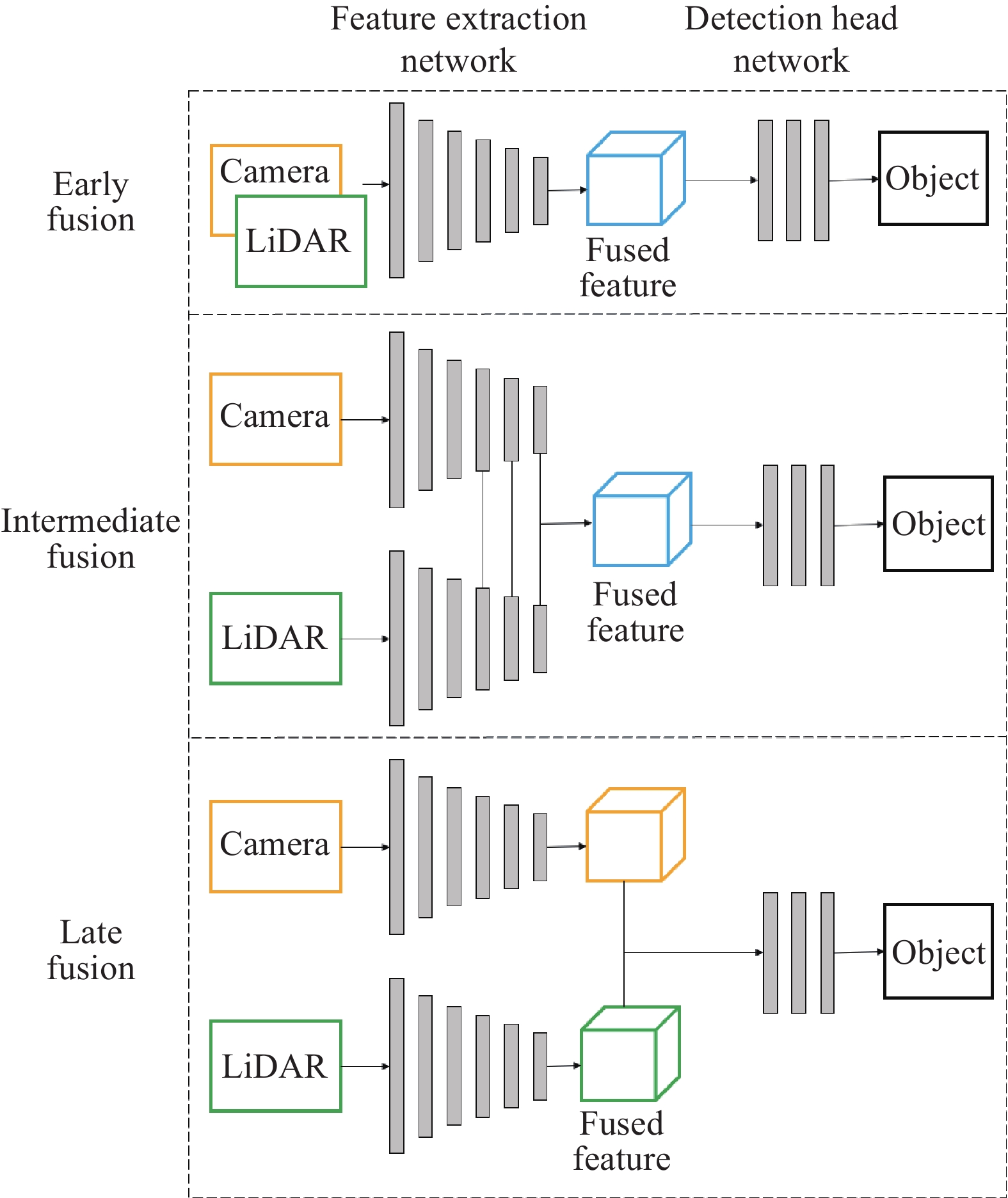

3.4.1 与相机融合

LiDAR与相机融合的主要挑战在于确定LiDAR点云的数据表现形式以及融合的时机. 大多数方法是将LiDAR三维点云转换为相机视角的二维特征图,从而通过神经网络实现快速且良好的数据融合. 文献[63]总结了三种三维点云转换二维特征图的方法,分别转换为距离扫描图像、转化为图像平面的稀疏深度图和对稀疏深度图小邻域内的稀疏点间插值得到密集深度图像. 在包含强曝光、雨雪天气、传感器故障等场景的自制AdverseKITTI数据集上的测试结果表明,融合为密集深度图像后的目标检测性能表现最佳. 对于LiDAR与相机的融合时机,以数据融合发生在目标检测网络的阶段作为分类标准,可分为早期融合、中期融合和晚期融合. 如图3所示,早期融合是指多传感器数据在输入网络前就被组合为一个统一的输入张量;中期融合是指多传感器数据在特征提取网络的浅层部分分别进行独立特征提取,在深层部分进行特征图级联融合;晚期融合是指对多传感器数据分别进行完全独立地特征提取,将多传感器数据的最终特征图进行融合,并作为检测头网络的输入. 文献[63]的实验证明,传感器数据融合得越晚,目标检测精度就越高. 为解决晚期融合的方法在某一传感器故障或受到干扰时无法运行的问题,文献[64]提出了一种新的鲁棒训练策略(Robust learning method,RLM),RLM随机选择一种传感器数据并将其设置为无穷大以模拟传感器故障,或在相机或点云深度图像中,使用白色多边形代表干扰,并将良好的天气数据、部分受干扰的数据和完全受损的数据以1∶2∶4的比例用于训练,实验结果表明,RLM可使网络在存在干扰的数据中学习处理未知噪声,在恶劣天气情况下或传感器发生故障时能极大增强检测器的性能.

文献[65]提出在中期融合框架加入全局–局部注意力模块,进一步融合局部和全局信息,该方法在小雾、浓雾和雪天条件下,比其他融合方法具有更优越的性能. 文献[66]提出在计算注意力时加入对估计LiDAR特征与相机特征不确定性的度量,根据不确定性的高低水平,分别采用最大池化或平均池化聚合空间特征. 最后使用经融合加权后的相机和LiDAR特征进行目标检测. 在包含极端天气和光照变化的STF数据集上的实验结果表明,该方法能有效过滤噪声,提高对汽车和行人等目标的检测精度. 与上述方法均在主干特征提取网络进行多模态融合的思路不同,文献[67]设计了一个模态交错的融合框架CrossFusion,在RPN阶段使用交叉解码器融合目标的多尺度图像特征和点云BEV特征,用于微调目标检测结果.

3.4.2 与毫米波雷达融合

文献[68]提出了具有两级融合机制的网络结构RadarNet,在早期将Radar和LiDAR的几何信息以体素的形式通过通道维度连接起来,以提高远距目标检测的性能;在晚期使用注意力机制将LiDAR目标与Radar目标进行融合,以提高动态轨迹估计的性能. 在nuScenes数据集上的实验结果表明,利用Radar数据可以提高探测远处物体和理解动态物体运动的感知能力. 文献[69]提出了双向LiDAR–Radar融合框架Bi-LRFusion,从LiDAR分支中学习重要细节来丰富Radar的局部特征,以缓解Radar数据的高度信息缺乏和极端稀疏问题. 在nuScenes数据集和牛津雷达机器人车ORR数据集[70]上的实验结果表明,提升Radar数据的质量有助于提升三维目标检测的精度. 文献[71]针对Radar和LiDAR数据具有不同特征和噪声分布的问题,提出了交互的多模态多尺度的融合方法M2-Fusion,利用自注意机制从每个模态学习特征并交换中间层信息. 为减少在XZ平面上Radar点云发散带来的误差,提出了一种基于高斯分布的数据预处理方法,有效地降低了数据噪声. 文献[72]提出了无锚框的目标检测方法RaLiBEV,通过在BEV下融合Radar的距离–方位热图和LiDAR点云的特征来估计可能的目标,并设计不同的标签分配策略以促进锚点分类与边界框回归的一致性,还提出了基于BEV的交互式Transformer模块以进一步提高目标检测的精度. 在ORR数据集上的测试结果表明,该方法在晴天和雾天的准确性大幅优于其他方法,Radar和LiDAR的融合可以在恶劣天气下实现鲁棒的目标检测.

3.4.3 多传感器融合

天气条件会导致各种传感器的不对称退化,为此,文献[22]提出了一种基于熵驱动的自适应融合特征单阶段目标检测网络,将所有传感器数据投影到相机坐标系中,并使用不同网络分支分别进行特征提取. 在特征融合时,计算各传感器的熵特征图用以缩放每个传感器的特征,减小熵低的区域,放大熵增的区域,实现自适应特征融合. 该方法使用晴朗天气数据进行训练,使用复杂天气数据进行评估,其目标检测精度高于单模态、多模态以及域适应方法,并满足实时处理速度. 文献[73]提出将多传感器数据的特征投影到鸟瞰图进行融合,并在融合前先进行空间和语义上的特征对齐. 对多模态特征图仅使用轻量化的检测头就足以得到比单模态[6,74]或双模态目标检测器[75−76]更精确、鲁棒的结果. 该方法在涵盖欧洲多个国家的不同路况(大城市、农村地区和高速公路)和不同天气条件(晴天、雨天、阴天)的Bosch数据集上进行了测试,实验结果表明,融合相机、Radar和LiDAR三种传感器数据的方法对天气条件的鲁棒性最强,可将检测范围扩大到225 m,并使召回率得到显著提升. 文献[77]提出了一种分段融合视锥体的多传感器目标检测方法,将相机图像中的2D检测框、通过视锥体关联的方式确定其在LiDAR和Radar点云中的区域,并将目标在不同模态中的特征进行分段分布式特征级融合. 该方法在nuScenes数据集、Radiate恶劣天气数据集和真实场景中均进行了测试,相比LiDAR–相机融合方法F-PointNet[9]、相机–Radar融合方法CenterFusion[78]和三传感器融合方法DWD-Fusion[79],该方法在复杂天气下具有最高的平均精度.

在采用合理融合策略的前提下,融合传感器的数量越多,其抗天气干扰能力越强. 针对传感器的特点设计出有效的融合框架,最大化各传感器的优势,是当前研究最为关注的问题之一. 目前对于融合框架的设计已从多个方向取得了进展,包括基于注意力的特征融合,在不同模态中开发更可靠的同质表示,以及设计更复杂、更具鲁棒性的统一框架等,增强点云目标检测方法应对复杂天气的鲁棒性[80].

4. 结论与展望

本文概述了近年来复杂天气条件下点云目标检测的挑战及研究现状. 目前方法主要集中在数据增强、点云去噪、模型改进和多传感器融合的设计上. 通过综合分析研究现状及实际需求,推测未来研究将继续沿用深度学习方法,并从数据、模型、学习方法、应用等四个方面开展研究:

(1)数据引擎:自动驾驶技术的成熟度与数据规模呈正相关. 已有的从复杂天气条件下获取的点云目标检测数据集的覆盖场景远不能反映现实世界中存在的复杂多样的驾驶场景,且数据量及标注量难以满足具有强鲁棒性的深度学习大模型的训练需求,亟需更多的真实世界数据集来训练和验证深度学习模型. 随着自动驾驶车辆的普及,获取真实的原始车载传感器数据已不是难事,因此开发覆盖数据收集、天气及目标框标注、算法评测、难样例选取等流程的复杂天气下自动驾驶数据自动化处理软件,有望大幅提高真实数据规模和质量. 另外,通过天气模拟方法可以大批量生成复杂天气数据及标注框,但开发更具真实性的天气模拟方法、以及评估生成数据真实性的方法有待进一步研究.

(2)端到端模型:复杂天气下激光点云中的大量噪点对物体关键点检测造成严重干扰,现有基于滤波的去噪方法已被证明不如基于深度学习的方法. 针对稀疏异构点云,如何将其转换为有序的表示,使其能够使用生成对抗网络进行处理,将是一个有待研究的方向. 另外,先对原始点云数据进行去噪处理,再进行目标检测的方法,将导致运算成本有所增加,因此,未来算法将逐渐转向对统一的深度学习网络结构的设计,对噪声、遮挡鲁棒的物体关键点特征的提取,以及对轻量化多天气鲁棒的目标检测模型等方向的研究.

(3)无监督预训练:针对复杂天气的长尾效应以及数据分布不均匀的问题,在最近的工作中,无监督学习方法,如半监督、弱监督和自监督学习,已被证明可以有效解决长尾问题. 其中,无监督学习方法在自然语言处理和图像处理中得到了广泛的应用,在点云目标检测领域进行了探索. 然而,应用于复杂天气目标检测领域的无监督学习方法在很大程度上仍未得到探索. 另外,随着硬件技术的不断进步,大模型在自动驾驶领域的应用前景广阔,未来可能利用超大规模点云数据集进行无监督预训练,并使用复杂天气点云数据对预训练的大模型进行微调,有望显著提高目标检测性能.

(4)落地实际应用:与单模态方法相比,多模态方法在潜在空间中具有全面的表示,然而,当前研究多在具有完备标定的多传感器数据集上进行实验和验证,而忽略了在实际部署时,由于传感器之间的时间戳错位,可能导致融合过程中出现特征时空异步问题. 而且,还需要考虑模型精度和模型复杂度之间的权衡问题,基于早期融合的细粒度融合方法难以直接应用于实时应用,需要大量的计算资源和高性能硬件来进行推理. 另外,当前算法主要基于公共数据集等有限的驾驶感知环境进行测试和验证,因此,如何构建合理的评价机制来评估其在真实驾驶场景中的性能水平,也是一个有待深入研究的方向.

-

图 1 点云目标检测数据集采集环境. (a) KITTI数据集[18](晴天开放道路); (b) CADC数据集[21](雪天开放道路);(c) STF数据集[22](雪天开放道路); (d) WADS数据集[23](雪天开放道路); (e) LIBRE数据集[24](雨气象室); (f) RADIATE数据集[26](雾天开放道路)

Figure 1. Acquisition environment of point cloud datasets: (a) KITTI dataset[18] (clear weather open road); (b) CADC dataset[21] (snowy open road); (c) STF dataset[22] (snowy open road); (d) WADS dataset[23] (snowy open road); (e) LIBRE dataset[24] (rainy weather chamber);(f) RADIATE dataset[26] (foggy open road)

表 1 复杂天气下点云目标检测数据集

Table 1 LiDAR object detection datasets acquired under adverse weather conditions

Type Dataset Scene Weather LiDAR Ground truth Open road Chamber Rain Fog Snow Classes Annotations Main-

streamKITTI[18] √ HDL-64E 3 2.0×105 nuScenes[19] √ √ HDL-32E 23 1.4×106 Waymo[20] √ √ 1×360° 75 m range, 4×LaserBear Honeycomb 4 1.2×107 Adverse

weatherCADC[21] √ √ VLP-32C 10 3.0×105 STF[22] √ √ √ √ √ VLP-32C, HDL64-S3 4 1.0×105 WADS[23] √ √ 2×VLP-16 22 pointwise 3.6×109 LIBRE[24] √ √ √ VLS-128, HDL64-S2, HDL-32E, VLP-32C, VLP-16, Pandar64, Pandar40P, OS1-64, OS1-16, RS-Lidar32 Oxford RobotCar[25] √ √ √ √ 2×SICK LMS-151 (2D), SICK LD-MRS (3D) RADIATE[26] √ √ √ √ 2×HDL-32E 8 2.0×105 SemanticSpray[27] √ √ VLP32C 1 pointwise SemanticSpray++[28] √ √ VLP32C 2 3.0×103 -

[1] Wu Y T, Wang Y Y, Zhang S W, et al. Deep 3D object detection networks using LiDAR data: A review. IEEE Sens J, 2021, 21(2): 1152 doi: 10.1109/JSEN.2020.3020626

[2] Rusu R B. Semantic 3D object maps for everyday manipulation in human living environments. KI Kunstliche Intell, 2010, 24(4): 345 doi: 10.1007/s13218-010-0059-6

[3] Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks. Commun ACM, 2017, 60(6): 84 doi: 10.1145/3065386

[4] Chen X Z, Ma H M, Wan J, et al. Multi-view 3D object detection network for autonomous driving // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 6526

[5] Zhou Y, Tuzel O. VoxelNet: End-to-end learning for point cloud based 3D object detection // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 4490

[6] Lang A H, Vora S, Caesar H, et al. PointPillars: Fast encoders for object detection from point clouds // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 12689

[7] Yan Y, Mao Y X, Li B. SECOND: Sparsely embedded convolutional detection. Sensors, 2018, 18(10): 3337 doi: 10.3390/s18103337

[8] Wu Y T, Zhang S W, Ogai H, et al. Realtime single-shot refinement neural network with adaptive receptive field for 3D object detection from LiDAR point cloud. IEEE Sens J, 2021, 21(21): 24505 doi: 10.1109/JSEN.2021.3114345

[9] Qi C R, Liu W, Wu C X, et al. Frustum PointNets for 3D object detection from RGB-D data // Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City, 2018: 918

[10] Shi S S, Wang X G, Li H. PointRCNN: 3D object proposal generation and detection from point cloud // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Long Beach, 2019: 770

[11] Shi S S, Wang Z, Shi J P, et al. From points to parts: 3D object detection from point cloud with part-aware and part-aggregation network. IEEE Trans Pattern Anal Mach Intell, 2021, 43(8): 2647

[12] Charles R Q, Hao S, Mo K C, et al. PointNet: Deep learning on point sets for 3D classification and segmentation // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Honolulu, 2017: 77

[13] Qi C, Yi L, Su H, et al. PointNet++: Deep hierarchical feature learning on point sets in a metric space // Proceedings of the 31st International Conference on Neural Information Processing Systems. Long Beach, 2017: 5105

[14] Yang Z T, Sun Y N, Liu S, et al. 3DSSD: Point-based 3D single stage object detector // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 11037

[15] Chen C, Chen Z, Zhang J, et al. SASA: Semantics-augmented set abstraction for point-based 3D object detection // Proceedings of the AAAI Conference on Artificial Intelligence. 2022, 36(1): 221

[16] Hahner M, Sakaridis C, Dai D X, et al. Fog simulation on real LiDAR point clouds for 3D object detection in adverse weather // 2021 IEEE/CVF International Conference on Computer Vision (ICCV). Montreal, 2021: 15263

[17] Hahner M, Sakaridis C, Bijelic M, et al. LiDAR snowfall simulation for robust 3D object detection // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. New Orleans, 2022: 16343

[18] Geiger A, Lenz P, Urtasun R. Are we ready for autonomous driving? The KITTI vision benchmark suite // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Providence, 2012: 3354

[19] Caesar H, Bankiti V, Lang A H, et al. nuScenes: A multimodal dataset for autonomous driving // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 11618

[20] Sun P, Kretzschmar H, Dotiwalla X, et al. Scalability in perception for autonomous driving: Waymo open dataset // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 2443

[21] Pitropov M, Garcia D E, Rebello J, et al. Canadian adverse driving conditions dataset. Int J Rob Res, 2021, 40(4-5): 681 doi: 10.1177/0278364920979368

[22] Bijelic M, Gruber T, Mannan F, et al. Seeing through fog without seeing fog: Deep multimodal sensor fusion in unseen adverse weather // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Seattle, 2020: 11679

[23] Kurup A M, Bos J. DSOR: A scalable statistical filter for removing falling snow from LiDAR point clouds in severe winter weather [J/OL]. arXiv preprint (2021–09–15) [2024–05–26]. https://arxiv.org/abs/2109.07078

[24] Carballo A, Lambert J, Monrroy A, et al. LIBRE: The multiple 3D LiDAR dataset // 2020 IEEE Intelligent Vehicles Symposium (IV). Las Vegas, 2020: 1094

[25] Maddern W, Pascoe G, Gadd M, et al. Real-time kinematic ground truth for the Oxford RobotCar dataset [J/OL]. arXiv preprint (2020–02–24) [2024–05–26]. https://arxiv.org/abs/2002.10152

[26] Sheeny M, De Pellegrin E, Mukherjee S, et al. RADIATE: A radar dataset for automotive perception in bad weather // 2021 IEEE International Conference on Robotics and Automation (ICRA). Xi’an, 2021: 1

[27] Piroli A, Dallabetta V, Kopp J, et al. Energy-based detection of adverse weather effects in LiDAR data. IEEE Rob Autom Lett, 2023, 8(7): 4322 doi: 10.1109/LRA.2023.3282382

[28] Piroli A, Dallabetta V, Kopp J, et al. SemanticSpray++: A multimodal dataset for autonomous driving in wet surface conditions//2024 IEEE Intelligent Vehicles Symposium (IV). Jeju Island, 2024: 3085

[29] Linnhoff C, Elster L, Rosenberger P, et al. Road spray in Lidar and radar data for individual moving objects [J/OL]. TUdatalib (2022–04–01) [2024–05–26]. https://doi.org/10.48328/tudatalib-930

[30] Chen Y K, Liu J H, Zhang X Y, et al. VoxelNeXt: Fully sparse VoxelNet for 3D object detection and tracking //Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver, 2023: 21674

[31] Piroli A, Dallabetta V, Kopp J, et al. Towards robust 3D object detection in rainy conditions // International Conference on Intelligent Transportation Systems (ITSC ). Bilbao, 2023: 3471

[32] Rasshofer R H, Spies M, Spies H. Influences of weather phenomena on automotive laser radar systems. Adv Radio Sci, 2011, 9: 49 doi: 10.5194/ars-9-49-2011

[33] Bijelic M, Gruber T, Ritter W. A benchmark for lidar sensors in fog: Is detection breaking down? // 2018 IEEE Intelligent Vehicles Symposium (IV). Changshu, 2018: 760

[34] Heinzler R, Schindler P, Seekircher J, et al. Weather influence and classification with automotive lidar sensors // 2019 IEEE Intelligent Vehicles Symposium (IV). Paris, 2019: 1527

[35] Goodin C, Carruth D, Doude M, et al. Predicting the influence of rain on LIDAR in ADAS. Electronics, 2019, 8(1): 89 doi: 10.3390/electronics8010089

[36] Hasirlioglu S, Riener A. A model-based approach to simulate rain effects on automotive surround sensor data // 2018 21st International Conference on Intelligent Transportation Systems (ITSC). Maui, 2018: 2609

[37] Teufel S, Volk G, Von Bernuth A, et al. Simulating realistic rain, snow, and fog variations for comprehensive performance characterization of LiDAR perception // 2022 IEEE 95th Vehicular Technology Conference. Helsinki, 2022: 1

[38] Kilic V, Hegde D, Sindagi V, et al. Lidar light scattering augmentation (LISA): Physics-based simulation of adverse weather conditions for 3D object detection [J/OL]. arXiv preprint (2021–07–14) [2024–05–26]. https://arxiv.org/abs/2107.07004

[39] Liu Y H, Tian Y L, Sun B Y, et al. Parallel LiDARs meet the foggy weather. IEEE J Radio Freq Identif, 2022, 6: 867 doi: 10.1109/JRFID.2022.3203733

[40] Milz S, Rüdiger T, Süss S. Aerial GANeration: Towards realistic data augmentation using conditional gans // Proceedings of the European Conference on Computer Vision (ECCV) Workshops. Munich, 2018: 59

[41] Sallab A E, Sobh I, Zahran M, et al. LiDAR sensor modeling and data augmentation with gans for autonomous driving [J/OL]. arXiv preprint (2019–05–17) [2024–05–26]. https://arxiv.org/abs/1905.07290

[42] Dosovitskiy A, Ros G, Codevilla F, et al. CARLA: An open urban driving simulator // Conference on Robot Learning. California, 2017: 1

[43] Zhu J Y, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Venice, 2017: 2242

[44] Lee J, Shiotsuka D, Nishimori T, et al. GAN-based LiDAR translation between sunny and adverse weather for autonomous driving and driving simulation. Sensors, 2022, 22(14): 5287 doi: 10.3390/s22145287

[45] Vattem T, Sebastian G, Lukic L. Rethinking LiDAR Object Detection in adverse weather conditions //2022 International Conference on Robotics and Automation (ICRA). Philadelphia, 2022: 5093

[46] Rusu R B, Cousins S. 3D is here: Point cloud library (PCL) // 2011 IEEE International Conference on Robotics and Automation. Shanghai, 2011: 1

[47] Charron N, Phillips S, Waslander S L. De-noising of lidar point clouds corrupted by snowfall // 2018 15th Conference on Computer and Robot Vision (CRV). Toronto, 2018: 254

[48] Balta H, Velagic J, Beglerovic H, et al. 3D registration and integrated segmentation framework for heterogeneous unmanned robotic systems. Remote Sens, 2020, 12(10): 1608 doi: 10.3390/rs12101608

[49] Park J I, Park J, Kim K S. Fast and accurate desnowing algorithm for LiDAR point clouds. IEEE Access, 2020, 8: 160202 doi: 10.1109/ACCESS.2020.3020266

[50] Heinzler R, Piewak F, Schindler P, et al. CNN-based lidar point cloud de-noising in adverse weather. IEEE Rob Autom Lett, 2020, 5(2): 2514 doi: 10.1109/LRA.2020.2972865

[51] Piewak F, Pinggera P, Schäfer M, et al. Boosting LiDAR-Based semantic labeling by cross-modal training data generation // Proceedings of the European Conference on Computer Vision (ECCV) Workshops. Munich, 2018: 497

[52] Seppänen A, Ojala R, Tammi K. 4DenoiseNet: Adverse weather denoising from adjacent point clouds. IEEE Rob Autom Lett, 2023, 8(1): 456 doi: 10.1109/LRA.2022.3227863

[53] Yu M Y, Vasudevan R, Johnson-Roberson M. LiSnowNet: Real-time snow removal for LiDAR point clouds // 2022 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Kyoto, 2022: 6820

[54] Bergius J. LiDAR Point Cloud De-noising for Adverse Weather [Dissertation]. Halmstad: Halmstad University, 2022

[55] Triess L T, Dreissig M, Rist C B, et al. A survey on deep domain adaptation for LiDAR perception // 2021 IEEE Intelligent Vehicles Symposium Workshops (IV Workshops). Nagoya, 2021: 350

[56] Lin J, Yin H, Yan J, et al. Improved 3D object detector under snowfall weather condition based on LiDAR point cloud. IEEE Sens J, 2022, 22(16): 16276 doi: 10.1109/JSEN.2022.3188985

[57] Caine B, Roelofs R, Vasudevan V, et al. Pseudo-labeling for scalable 3D object detection [J/OL]. arXiv preprint (2021–03–02) [2024–05–26]. https://arxiv.org/abs/2103.02093

[58] Do A T, Yoo M. LossDistillNet: 3D object detection in point cloud under harsh weather conditions. IEEE Access, 2022, 10: 84882 doi: 10.1109/ACCESS.2022.3197765

[59] Przewięźlikowski M, Śmieja M, Struski Ł. Estimating conditional density of missing values using deep gaussian mixture model // Neural Information Processing: 27th International Conference. Bangkok, 2020: 220

[60] Zheng W, Tang W L, Jiang L, et al. SE-SSD: Self-ensembling single-stage object detector from point cloud // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville, 2021: 14489

[61] Huang Y, Du C, Xue Z, et al. What makes multi-modal learning better than single (provably)// Proceedings of the 35th International Conference on Neural Information Processing Systems. Online Conference, 2021: 10944

[62] 陈鹏, 李擎, 张德政, 等. 多模态学习方法综述. 工程科学学报, 2020, 42(5):557 Chen P, Li Q, Zhang D Z, et al. A survey of multimodal machine learning. Chin J Eng, 2020, 42(5): 557

[63] Pfeuffer A, Dietmayer K. Optimal sensor data fusion architecture for object detection in adverse weather conditions // 2018 21st International Conference on Information Fusion (FUSION). Cambridge , 2018: 1

[64] Pfeuffer A, Dietmayer K. Robust semantic segmentation in adverse weather conditions by means of sensor data fusion // 2019 22th International Conference on Information Fusion (FUSION). Ottawa, 2019: 1

[65] Chaturvedi S S, Zhang L, Yuan X Y. Pay “attention” to adverse weather: Weather-aware attention-based object detection // 2022 26th International Conference on Pattern Recognition (ICPR). Montreal, 2022: 4573

[66] Kim T L, Arshad S, Park T H. Adaptive feature attention module for robust visual–LiDAR fusion-based object detection in adverse weather conditions. Remote Sens, 2023, 15(16): 3992 doi: 10.3390/rs15163992

[67] Yang Y, Ma W, Chen H, et al. CrossFusion: Interleaving cross-modal complementation for noise-resistant 3D object detection [J/OL]. arXiv preprint (2023–04–19) [2024–05–26]. https://arxiv.org/abs/2304.09694

[68] Yang B, Guo R, Liang M, et al. RadarNet: Exploiting radar for robust perception of dynamic objects // Proceedings of the European Conference on Computer Vision (ECCV) Workshops. Glasgow, 2020: 496

[69] Wang Y J, Deng J J, Li Y, et al. Bi-LRFusion: Bi-directional LiDAR-radar fusion for 3D dynamic object detection // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Vancouver, 2023: 13394

[70] Barnes D, Gadd M, Murcutt P, et al. The oxford radar robotcar dataset: A radar extension to the oxford robotcar dataset // 2020 IEEE International Conference on Robotics and Automation (ICRA). Paris, 2020: 6433

[71] Wang L, Zhang X Y, Li J, et al. Multi-modal and multi-scale fusion 3D object detection of 4D radar and LiDAR for autonomous driving. IEEE Trans Veh Technol, 2023, 72(5): 5628 doi: 10.1109/TVT.2022.3230265

[72] Yang Y, Liu J, Huang T, et al. RaLiBEV: Radar and LiDAR BEV fusion learning for anchor box free object detection system [J/OL]. arXiv preprint (2022–11–11) [2024–05–26]. https://arxiv.org/abs/2211.06108

[73] Li Y W, Yu A W, Meng T J, et al. DeepFusion: Lidar-camera deep fusion for multi-modal 3D object detection // 2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). New Orleans, 2022: 17161

[74] Yin T W, Zhou X Y, Krähenbühl P. Center-based 3D object detection and tracking // Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Nashville, 2021: 11779

[75] Xu S Q, Zhou D F, Fang J, et al. FusionPainting: Multimodal fusion with adaptive attention for 3D object detection // 2021 IEEE International Intelligent Transportation Systems Conference (ITSC). Indianapolis, 2021: 3047

[76] Yoo J H, Kim Y, Kim J, et al. 3 D-CVF: Generating joint camera and LiDAR features using cross-view spatial feature fusion for 3D object detection [J/OL]. arXiv preprint (2020–04–27) [2024–05–26]. https://arxiv.org/abs/2004.12636

[77] Tao C B, Bian W T, Wang C, et al. 3D object detection algorithm based on multi-sensor segmental fusion of frustum association for autonomous driving. Appl Intell, 2023, 53(19): 22753 doi: 10.1007/s10489-023-04630-4

[78] Nabati R, Qi H. Centerfusion: Center-based radar and camera fusion for 3D object detection // Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. Waikoloa , 2021: 1526

[79] Liu Q H, Zhou W Q, Zhang Y K, et al. Multi-target detection based on multi-sensor redundancy and dynamic weight distribution for driverless cars // 2021 International Conference on Communications, Information System and Computer Engineering (CISCE). Beijing, 2021: 229

[80] 王艺娴, 胡雨凡, 孔庆群, 等. 三维点云语义分割:现状与挑战. 工程科学学报, 2023, 45(10):1653 Wang Y X, Hu Y F, Kong Q Q, et al. 3D point cloud semantic segmentation: state of the art and challenges. Chin J Eng, 2023, 45(10): 1653

下载:

下载: